Datacenter scale computing

データセンタ全体のデータを一体化して扱うDatacenter scale computingでは、CPU・GPU・DRAM・SCM・Flash memoryといった膨大なリソースをプールし、アプリケーションに応じて最適なハードウエアを再構成します。

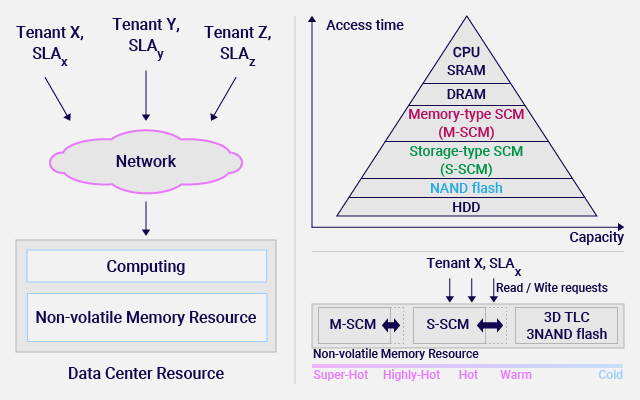

IoTなどに向けてAIを用いたリアルタイムの情報処理の進展により、データセンタで扱うデータの量は増加しています。従来はラックスケールで計算を実行していました。今後は高速な不揮発性メモリ(ストレージクラスメモリ:SCM)の導入、インターコネクトの高速化により、ストレージやインターコネクトのボトルネックが解消されます。その結果、数百メートル規模のデータセンタ全体で膨大なデータを一体化して扱うことが可能になります。竹内研究室ではこのようなDatacenter scale computingの研究に取り組み、CPU・GPU・SCM・Flash memoryといった膨大なリソースをプールし、アプリケーションに応じて最適なハードを再構成する技術を研究しています。例えばアクセス頻度が非常に高いSuper-Hot dataは高速で少容量なM-SCMに、次にアクセス頻度が高いHot dataは中速・中容量なS-SCMに、あまりアクセスされないCold dataはFlash memoryに記憶する、データマネジメント技術の研究を行っています。