Transformer

Attention機構を用いて学習し自然言語処理や画像分類を行うTransformerに向けて、演算の特徴に応じてComputation-in-Memoryを使い分けることでエッジでの高精度な推論を可能にします。

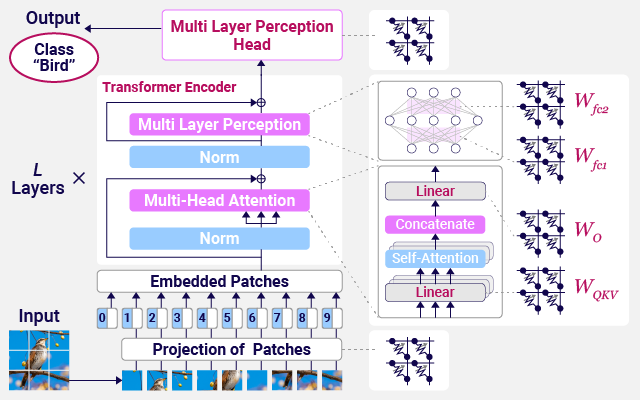

Attention機構を用いて学習し自然言語処理や画像分類を行うTransformerモデルは、畳み込み層を持つConvolutional Neural Network (CNN)や時系列データ処理の得意なRecurrent Neural Network (RNN)とは異なる演算が必要です。Attention機構は過去の重要な情報への「注意」を学習します。Transformerモデルが軽量化しエッジでの演算が可能な時代には、Transformer内の演算の特性に応じたComputation-in-Memory (CiM)の使い分けが必要となります。書き換えが必要なTransformerのAttention層にはSRAM CiMを用い、データ保持が必要な線形層にはReRAM CiMを用いることで、エネルギー効率の高いCiMによるTransformerの演算を可能にします。